Стоит ли смотреть в сторону data science?

Содержание:

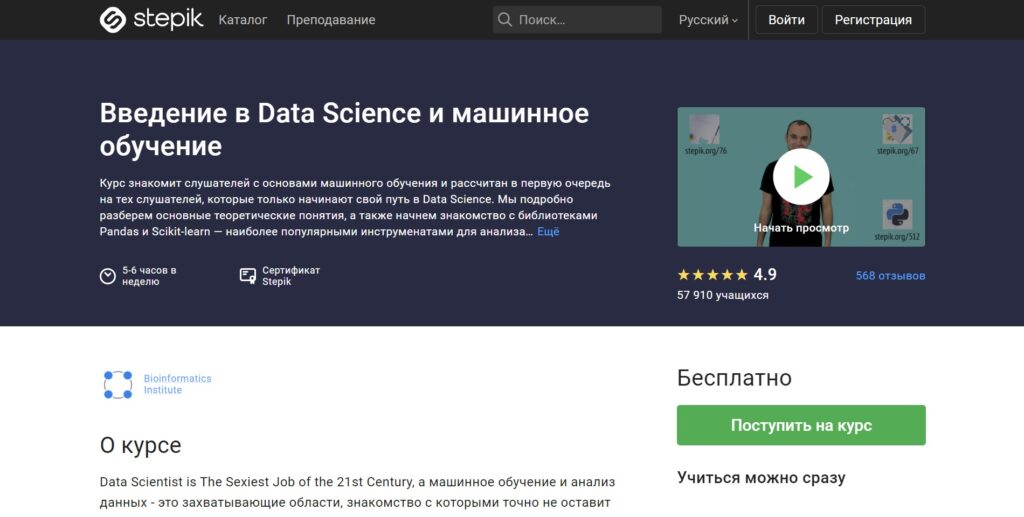

«Введение в Data Science и машинное обучение» от Института биоинформатики

Длительность курса: 30 уроков.

Формат обучения: видеоуроки + тесты + интерактивные задачи.

Программа обучения:

- О чём курс?

- Big Data, Deep Machine Learning — основные понятия.

- Модель, начнём с дерева.

- Pandas, Dataframes.

- Фильтрация данных

- Группировка и агрегация.

- Визуализация, seaborn.

- Практические задания: Pandas.

- Секретный гость.

- Stepik ML contest — это ещё что такое?

- Stepik ML contest — data preprocessing.

- Какого музыканта Beatles я загадал или entropy reduction.

- Немного теории и энтропии.

- Titanic: Machine Learning from Disaster.

- Обучение, переобучение, недообучение и кросс-валидация.

- Последний джедай или метрики качества модели.

- Подбор параметров и ROC and Roll.

- Практика, Scikit-learn, fit, predict, you are awesome.

- ML на практике — автокорректор ошибок правописания.

- Секретный гость.

- Stepik ML contest.

- Снова возвращаемся к деревьям.

- Random forest.

- Зачем знать что-то ещё, если есть Random Forest?

- Секретный гость.

- И на Марсе будут яблони цвести.

- Нейроэволюция.

- Трюки в Pandas.

- Вот и всё, а что дальше?

- Stepik ML contest.

Что освоите:

- Основные понятия Data Science и Machine Learning

- Наиболее популярные Python-библиотеки для анализа данных — Pandas и Scikit-learn

- Начать обучение можно сразу после регистрации

- Обучение проводят лучшие преподаватели Института биоинформатики

- Современная программа обучения

- Изложение материала простым языком

- Можно бесплатно получить сертификат по окончании обучения

Преподаватели:

Какие компании занимаются большими данными

Первыми с большими данными, либо с «биг дата», начали работать сотовые операторы и поисковые системы. У поисковиков становилось все больше и больше запросов, а текст тяжелее, чем цифры. На работу с абзацем текста уходит больше времени, чем с финансовой транзакцией. Пользователь ждет, что поисковик отработает запрос за долю секунды — недопустимо, чтобы он работал даже полминуты. Поэтому поисковики первые начали работать с распараллеливанием при работе с данными.

Чуть позже подключились различные финансовые организации и ритейл. Сами транзакции у них не такие объемные, но большие данные появляются за счет того, что транзакций очень много.

Количество данных растет вообще у всех. Например, у банков и раньше было много данных, но для них не всегда требовались принципы работы, как с большими. Затем банки стали больше работать с данными клиентов. Стали придумывать более гибкие вклады, кредиты, разные тарифы, стали плотнее анализировать транзакции. Для этого уже требовались быстрые способы работы.

Сейчас банки хотят анализировать не только внутреннюю информацию, но и стороннюю. Они хотят получать большие данные от того же ритейла, хотят знать, на что человек тратит деньги. На основе этой информации они пытаются делать коммерческие предложения.

Сейчас вся информация связывается между собой. Ритейлу, банкам, операторам связи и даже поисковикам — всем теперь интересны данные друг друга.

Полезные ссылки

- бесплатные курсы: Основы статистики;

- тренажеры: SQL;

- полезные материалы по продуктовой аналитике от команды МатеМаркетинга;

- чат с вакансиями в сфере анализа данных;

- канал с полезными материалами про работу с данными.

Артем Боровой: На мой взгляд, самый удобный путь — начать применять инструменты аналитика в своей текущей работе. Можно постепенно изучать языки и программы, а потом использовать их для своих задач. Конечно, не у всех может быть доступ к данным по месту работы, но для таких случаев есть площадки для самостоятельного обучения. Онлайн-курсы в этом плане проще и удобнее, так как человеку не нужно самому отбирать информацию, они помогают пройти по всем важным пунктам, дают материал в нужном темпе, погружают в комьюнити.

Краткое описание

Big Data Analyst работает с большими данными, его клиенты в основном представители бизнеса, но не только – технологии «биг дата» во многих странах на государственном уровне используются в здравоохранении, медицине, фармации. Обработка, анализ и интерпретация данных позволяют взглянуть на привычные вещи по-другому, выявить новые процессы, феномены и т. д. В идеале аналитики больших данных должны разбираться в той сфере, в которой ведут деятельность, но на практике это далеко не всегда так.

Главный инженер «Сбера» по разработке в Data Analytics

Однозначного определения больших данных пока еще нет, но чаще всего под Big Data подразумевают наборы неструктурированных и разнородных данных, существенно превосходящие традиционные реляционные (структурированные) базы данных по объему. Сведения совершенно разного формата в общий массив поступают из разнообразных источников (датчики, приложения, камеры видеонаблюдения, социальные сети и т. д.) и постоянно пополняются в режиме реального времени. Сбором и обработкой нужной для определенных целей информации занимается аналитик больший данных.

Рынок Big data в России

В 2017 году мировой доход на рынке big data должен достигнуть $150,8 млрд, что на 12,4% больше, чем в прошлом году. В мировом масштабе российский рынок услуг и технологий big data ещё очень мал. В 2014 году американская компания IDC оценивала его в $340 млн. В России технологию используют в банковской сфере, энергетике, логистике, государственном секторе, телекоме и промышленности.

Что касается рынка данных, он в России только зарождается. Внутри экосистемы RTB поставщиками данных выступают владельцы программатик-платформ управления данными (DMP) и бирж данных (data exchange). Телеком-операторы в пилотном режиме делятся с банками потребительской информацией о потенциальных заёмщиках.

|

15 сентября в Москве состоится конференция по большим данным Big Data Conference. В программе — бизнес-кейсы, технические решения и научные достижения лучших специалистов в этой области. Приглашаем всех, кто заинтересован в работе с большими данными и хочет их применять в реальном бизнесе. |

Обычно большие данные поступают из трёх источников:

- Интернет (соцсети, форумы, блоги, СМИ и другие сайты);

- Корпоративные архивы документов;

- Показания датчиков, приборов и других устройств.

Каким должен быть специалист по большим данным

Поскольку данные расположены на кластере серверов, для их обработки используется более сложная инфраструктура. Это оказывает большую нагрузку на человека, который с ней работает — система должна быть очень надежной.

Сделать надежным один сервер легко. Но когда их несколько — вероятность падения возрастает пропорционально количеству, и так же растет и ответственность дата-инженера, который с этими данными работает.

Аналитик big data должен понимать, что он всегда может получить неполные или даже неправильные данные. Он написал программу, доверился ее результатам, а потом узнал, что из-за падения одного сервера из тысячи часть данных была отключена, и все выводы неверны.

Взять, к примеру, текстовый поиск. Допустим все слова расположены в алфавитном порядке на нескольких серверах (если говорить очень просто и условно). И вот отключился один из них, пропали все слова на букву «К». Поиск перестал выдавать слово «Кино». Следом пропадают все киноновости, и аналитик делает ложный вывод, что людей больше не интересуют кинотеатры.

Поэтому специалист по большим данным должен знать принципы работы от самых нижних уровней — серверов, экосистем, планировщиков задач — до самых верхнеуровневых программ — библиотек машинного обучения, статистического анализа и прочего. Он должен понимать принципы работы железа, компьютерного оборудования и всего, что настроено поверх него.

В остальном нужно знать все то же, что и при работе с малыми данным. Нужна математика, нужно уметь программировать и особенно хорошо знать алгоритмы распределенных вычислений, уметь приложить их к обычным принципам работы с данными и машинного обучения.

Big data в банках

Помимо системы, описанной выше, в стратегии «Сбербанка» на 2014-2018 гг

говорится о важности анализа супермассивов данных для качественного обслуживания клиентов, управления рисками и оптимизации затрат. Сейчас банк использует Big data для управления рисками, борьбы с мошенничеством, сегментации и оценки кредитоспособности клиентов, управления персоналом, прогнозирования очередей в отделениях, расчёта бонусов для сотрудников и других задач

«ВТБ24» пользуется большими данными для сегментации и управления оттоком клиентов, формирования финансовой отчётности, анализа отзывов в соцсетях и на форумах. Для этого он применяет решения Teradata, SAS Visual Analytics и SAS Marketing Optimizer.

«Альфа-Банк» за большие данные взялся в 2013 году. Банк использует технологии для анализа соцсетей и поведения пользователей сайта, оценки кредитоспособности, прогнозирования оттока клиентов, персонализации контента и вторичных продаж. Для этого он работает с платформами хранения и обработки Oracle Exadata, Oracle Big data Appliance и фреймворком Hadoop.

«Тинькофф-банк» с помощью EMC Greenplum, SAS Visual Analytics и Hadoop управляет рисками, анализирует потребности потенциальных и существующих клиентов. Большие данные задействованы также в скоринге, маркетинге и продажах.

Сколько зарабатывает аналитик данных?

Мы проанализировали открытые вакансии на HH.ru и Хабр Карьера. Разброс зарплат оказался довольно большим. Что ожидаемо — он зависит от опыта и города, в котором работает аналитик. Стажеру в Перми предлагают 25 тыс. рублей, а аналитик данных в московском офисе международной компании зарабатывает 200 тыс. рублей.

Средние зарплаты получились такими:

Источник

Стажеры и junior-специалисты получают от 60 тыс. рублей. В 8% вакансий указана сумма ниже, но в основном они предлагают частичную занятость.

Руководители отделов и синьор-аналитики получают от 170 тыс. рублей. В некоторых вакансиях предлагают больше 250 тыс. рублей в месяц, но для них нужен опыт больше пяти лет в аналитике и большой пул компетенций.

В регионах ситуация иная. Максимальная зарплата, на которую можно рассчитывать, — 100 тыс. рублей. Но многие работают удаленно в своем городе, получая «столичную» зарплату. На сайте hh.ru удаленные вакансии для аналитиков данных составляют 15% от общего количества.

Big data — простыми словами

В современном мире Big data — социально-экономический феномен, который связан с тем, что появились новые технологические возможности для анализа огромного количества данных.

Для простоты понимания представьте супермаркет, в котором все товары лежат не в привычном вам порядке. Хлеб рядом с фруктами, томатная паста около замороженной пиццы, жидкость для розжига напротив стеллажа с тампонами, на котором помимо прочих стоит авокадо, тофу или грибы шиитаке. Big data расставляют всё по своим местам и помогают вам найти ореховое молоко, узнать стоимость и срок годности, а еще — кто, кроме вас, покупает такое молоко и чем оно лучше молока коровьего.

Кеннет Кукьер: Большие данные — лучшие данные

Сколько времени занимает обучение

У нас обучение идет полтора года. Они разбиты на шесть четвертей. В одних идет упор на программирование, в других — на работу с базами данных, в третьих — на математику.

В отличии, например, от факультета ИИ, здесь поменьше математики. Нет такого сильного упора на математический анализ и линейную алгебру. Знания алгоритмов распределенных вычислений нужны больше, чем принципы матанализа.

Но полтора года достаточно для реальной работы с обработкой больших данных только если у человека был опыт работы с обычными данными и вообще в ИТ. Остальным студентам после окончания факультета рекомендуется поработать с малыми и средними данными. Только после этого специалиста могут допустить к работе с большими. После обучения стоит поработать дата-саентистом — поприменять машинное обучение на разных объемах данных.

Когда человек устраивается в большую компанию — даже если у него был опыт — чаще всего его не допустят до больших объемов данных сразу, потому что цена ошибки там намного выше. Ошибки в алгоритмах могут обнаружиться не сразу, и это приведет к большим потерям.

Какие используются инструменты и технологии big data

Поскольку данные хранятся на кластере, для работы с ними нужна особая инфраструктура. Самая популярная экосистема — это Hadoop. В ней может работать очень много разных систем: специальных библиотек, планировщиков, инструментов для машинного обучения и многого другое. Но в первую очередь эта система нужна, чтобы анализировать большие объемы данных за счет распределенных вычислений.

Например, мы ищем самый популярный твит среди данных разбитых на тысяче серверов. На одном сервере мы бы просто сделали таблицу и все. Здесь мы можем притащить все данные к себе и пересчитать. Но это не правильно, потому что очень долго.

Поэтому есть Hadoop с парадигмами Map Reduce и фреймворком Spark. Вместо того, чтобы тянуть данные к себе, они отправляют к этим данным участки программы. Работа идет параллельно, в тысячу потоков. Потом получается выборка из тысячи серверов на основе которой можно выбрать самый популярный твит.

Map Reduce более старая парадигма, Spark — новее. С его помощью достают данные из кластеров, и в нем же строят модели машинного обучения.

Как работают Big Data

Основная идея больших данных заключается в следующем: чем больше информации вы знаете, тем быстрее вы сможете найти и принять правильное решение. В большинстве случаев процесс сбора информации полностью автоматизирован: есть продвинутые инструменты, которые запускают миллионы действий одновременно, чтобы дать компании наилучший результат.

Большие данные поступают из множества различных источников: информация о транзакциях, CRM, инструменты веб-аналитики, мобильные приложения, метеосводки, социальные сети, репозитории научных исследований, датчики данных в реальном времени, используемые в интернете вещей и так далее. Данные могут быть представлены в необработанном виде или предварительно обработаны с помощью инструментов интеллектуального анализа, чтобы они уже были готовы к использованию (например, чтобы аналитики компании разработали гипотезы).

Востребованность профессии

В июне 2021 года на сайте hh.ru было более 13 тысяч вакансий для аналитика данных.

Данные накапливаются с огромной скоростью. В 2018 году аналитическая компания IDC прогнозировала: за пять лет, в период с 2015 по 2020 год, объем цифровых данных в мире вырастет в два раза и составит 40 зеттабайт (один зеттабайт равен миллиону миллионов гигабайт) — но фактически накопление информации идет еще быстрее: в 2020 году объем информации уже достиг 59 зеттабайт. По оценкам Ассоциации больших данных, рынок Big Data в России ежегодно растет на 12%.

Для работы с таким количеством данных компаниям нужны специалисты. В 2019 году вакансий в области анализа данных стало больше в 9,6 раза, чем в 2015 году.

Источник

Важные личные качества

Big Data Analyst работает с огромными массивами информации, что накладывает отпечаток на его характер. Чтобы справляться с обязанностями, аналитику больших данных надо:

быть дисциплинированным, усидчивым, терпеливым и методичным;

уметь долго концентрировать внимание;

быть способным работать в режиме многозадачности;

обладать развитым техническим и аналитическим мышлением;

уметь работать в команде.

Кроме того, аналитик больших данных должен быть достаточно прагматичным, уверенным в своих силах, ведь от его умения делать выводы на основании полученной информации во многом зависит успех бизнеса и принятие стратегически важных решений.

История возникновения

Название Big Data появилось в 2000-х, но концепция обработки большого количества данных возникла гораздо раньше. Менялся только объем и масштаб. В 1960-х годах начали создаваться первые хранилища больших данных, а сорок лет спустя компании увидели, сколько наборов данных можно собрать с помощью онлайн-сервисов, сайтов, приложений и любых продуктов, с которыми взаимодействуют клиенты. Именно тогда начали набирать популярность первые сервисы Big Data (Hadoop, NoSQL и т.д.). Наличие таких инструментов стало необходимо, поскольку они упрощают и удешевляют хранение и анализ.

Большие данные часто характеризуются тремя факторами: большим объемом, большим разнообразием типов данных, хранящихся в системах, и скоростью, с которой данные генерируются, собираются и обрабатываются. Эти характеристики были впервые выявлены Дугом Лэйни, аналитиком в Meta Group Inc., в 2001 году. Компания Gartner популяризировала их после того, как в 2005 году приобрела Meta Group. Постепенно к этим описаниям больших данных стали добавляться и другие критерии (достоверность, ценность и так далее).

В 2008 году с Клиффорд Лина в спецвыпуске журнала Nature эксперт назвал взрывной рост потоков информации big data. В него он отнес любые массивы неоднородных данных свыше 150 Гб в сутки. С тех пор термин «большие данные» прочно укрепился.

19 бесплатных материалов

Теперь перейдем к бесплатным материалам по аналитике данных, Machine Learning, Data Science и Big Data. Мы собрали лучшие курсы, статьи и видеоролики на YouTube для начинающих IT-специалистов.

С помощью бесплатных материалов вы освоите азы аналитики и поймете, подходит вам эта профессия или нет.

«Анализ данных в R» — Stepik

Трехнедельный курс в рамках которого вы узнаете основные этапы статистического анализа R, считывания данных, предобработки данных, визуализации результатов и применения основных статистических методов.

После завершения курса вы получите сертификат Stepik.

«Математика и Python для анализа данных» — Coursera

Обучающий курс на платформе Coursera. Проводится от партнеров: Московский физико-технический институт, E-Learning Development Fund и Яндекс.

После прохождения обучения вы получите сертификат. Примерное время прохождения: 29 часов.

«Как стать специалистом по Data Science» — Яндекс.Практикум

Обучающая программа от Яндекс.Практикум. Вы станете специалистом по Data Science: вы освоите основы Python и анализа данных, предобработку данных, статистический анализ данных.

Бесплатно доступен вводный курс. Стоимость полного обучения: 104 000 руб.

«Машинное обучение и анализ данных» — Coursera

Курс о машинном обучении и анализе данных. Типовые задачи Machine Learning и анализа данных и методы их решения.

Курс проводят партнеры Coursera: Яндекс, Московский физико-технический институт и E-Learning Development Fund.

После успешного прохождения курса вы получите сертификат.

«Введение в науку о данных» — Coursera

Курс, который поможет стать исследователем данных. Проводится от партнера Coursera компании IBM.

Приблизительное время прохождения: 4 месяца. Язык: английский. Есть русские субтитры.

«Что такое наука о данных» — Coursera

Курс на Coursera в партнерстве с IBM. Вы узнаете, что такое наука о данных.

Приблизительное время прохождения: 10 часов. В итоге вы получите сертификат.

7 полезных видео на YouTube

Также мы подготовили для вас подборку бесплатных видео на YouTube по Big Data, анализу данных и Data Science. Нашли полезных 7 роликов.

1) Видео от GeekBrains о том, что такое аналитика Big Data:

2) Все о Data Science: интервью со специалистом в этой области:

3) Интервью с создателем главного российского BigData-алгоритма Артуром Хачуяном:

4) Видео про зарплаты в Big Data:

5) Первый урок курса «Введение в Анализ Данных»:

6) Основы Python для Data Science — видео от Skillbox:

7) Видео о том, что такое Data Science:

Полезные статьи: ТОП-6

Подборка статей для самостоятельного изучения:

- Как стать экспертом в Data Science — Tproger.

- Обзор профессии Data Scientist — Блог компании «Нетология» на Habr.

- Что такое Big Data — Rusbase

- Big Data от А до Я — Habr

- Что такое аналитика данных — Oracle

- Можно без опыта: что нужно знать начинающему дата-аналитику — VC

3 крупных скандала Big Data и Machine Learning в сфере безопасности

Наиболее критичные факапы в области больших данных за последнюю пару лет связаны с информационной безопасностью. Причем сейчас мы говорим не столько про утечки данных, сколько про их неправомерное использование. Несмотря на законодательные меры, в частности, введение GDPR в 2018 году, о чем мы подробно рассказывали здесь, даже крупнейшие data-driven компании нелегально обрабатывают персональные данные своих пользователей.

Например, соцсеть считают причастной к компании Cambridge Analytica, собравшей личные данные 50 миллионов пользователей в целях построения ML-моделей результатов президентских выборов в США. В связи с этим Facebook была оштрафована на Федеральной комиссией США по торговле на 5 миллиардов долларов и потеряла еще 40 миллиардов на падении акций . Также Facebook замечена в других инцидентах с персональными данными своих пользователей и оштрафована в октябре 2018 г. в Великобритании на 500 тысяч фунтов стерлингов, что составляет более 620 тысяч долларов. А в 2019 году в Италии на 1 миллион евро за утечку пользовательских данных была наказана в Италии .

Другой крупный скандал, связанный с Machine Learning, Big Data и большими деньгами также случился в 2019 году. Напомним, тогда с помощью технологии Deep Fake злоумышленники успешно имитировали голос руководителя фирмы, заставив замдиректора перевести на их счет около 220 тысяч евро. Такое неправомерное применение нейросетей и открытых данных о публичных персонах позволяет создать фейковые аудио и видеозаписи с их участием, что может привести к социальным, финансовым и политическим рискам. Кроме того, Deep Fake опасен для биометрических систем, которые активно внедряются в различные государственные сервисы.

Здесь также имеют место случаи с фотографиями невинных граждан, ошибочно попавшими в базу преступников. В частности, так в 2018 году в Москве был задержан молодой человек, возвращавшийся с концерта и не совершавший неправомерных действий. Против внедрения системы распознавания лиц на городских улицах уже подано несколько судебных исков, но пока все они отклонены. Более того, московская цифровизация задает тренд другим городам России: подобные системы распознавания на базе Big Data и Machine Learning уже вводятся в Калуге, Тюмени, Екатеринбурге и Белгородской области .

Система распознавания лиц становится неотъемлемым компонентом почти каждого города

Как безопасно вести проекты больших данных и машинного обучения, чтобы цифровизация не превратилась в скандал и принесла бизнесу пользу, вы узнаете на наших образовательных курсах в лицензированном учебном центре обучения и повышения квалификации ИТ-специалистов (менеджеров, архитекторов, инженеров, администраторов, Data Scientist’ов и аналитиков Big Data) в Москве:

- BDAM: Аналитика больших данных для руководителей

- DSEC: Безопасность озера данных Hadoop

Смотреть расписание

Записаться на курс

Источники

- https://habr.com/ru/news/t/482388/

- https://novayagazeta.ru/articles/2020/02/03/83759-big-data-na-krovi

- https://androidinsider.ru/smartfony/samye-krupnye-provaly-v-mire-tehnologij-v-2019-godu.html

- https://www.infowatch.ru/resources/analytics/leaks-monitoring/15759

- https://roskomsvoboda.org/54969/

How big data analytics works

Big data analytics refers to collecting, processing, cleaning, and analyzing large datasets to help organizations operationalize their big data.

1. Collect Data

Data collection looks different for every organization. With today’s technology, organizations can gather both structured and unstructured data from a variety of sources — from cloud storage to mobile applications to in-store IoT sensors and beyond. Some data will be stored in data warehouses where business intelligence tools and solutions can access it easily. Raw or unstructured data that is too diverse or complex for a warehouse may be assigned metadata and stored in a data lake.

2. Process Data

Once data is collected and stored, it must be organized properly to get accurate results on analytical queries, especially when it’s large and unstructured. Available data is growing exponentially, making data processing a challenge for organizations. One processing option is batch processing, which looks at large data blocks over time. Batch processing is useful when there is a longer turnaround time between collecting and analyzing data. Stream processing looks at small batches of data at once, shortening the delay time between collection and analysis for quicker decision-making. Stream processing is more complex and often more expensive.

3. Clean Data

Data big or small requires scrubbing to improve data quality and get stronger results; all data must be formatted correctly, and any duplicative or irrelevant data must be eliminated or accounted for. Dirty data can obscure and mislead, creating flawed insights.

4. Analyze Data

Getting big data into a usable state takes time. Once it’s ready, advanced analytics processes can turn big data into big insights. Some of these big data analysis methods include:

Что делает ученый по данным

Как и Data Analyst, исследователь данных тоже работает с информационными массивами путем выполнения следующих операций:

- поиск закономерностей в информационных наборах;

- подготовка данных к моделированию (выборка, очистка, генерация признаков, интеграция, форматирование);

- моделирование и визуализация данных;

- разработка и тестирование гипотез по улучшению бизнес-метрик через построение моделей машинного обучения (Machine Learning).

Data Scientist, в большинстве случаев, ориентирован на предиктивную аналитику, тогда как аналитик данных чаще всего рассматривает информацию пост-фактум. Тем не менее, основная цель исследователя данных созвучна главной рабочей цели аналитика Big Data – извлечение из информационных массивов сведений, полезных для бизнеса с точки зрения принятия оптимальных управленческих решений.

Портрет профессиональных компетенций ученого по данным

Как ИТ-решения и предиктивная аналитика помогают зарабатывать больше

Типовые ИТ-решения управления логистикой анализируют данные из транспортных заявок в ходе управления расписанием на погрузку/разгрузку. Отдельный объём данных получают от дополнительных статусов и настроек заказчика (расход топлива, скорость обработки заказа, время хранения товара на складе и др.).

Одними из первых в России о своей трансформации с упором на big data также заявили РЖД. В конце 2019 года они анонсировали цифровую платформу мультимодальных пассажирских перевозок со следующими компонентами:

- аналитика на базе машинного обучения,

- роботизированные коммуникации с человеком,

- дополненная реальность,

- машинное зрение,

- управление пользовательским опытом.

По итогам года, эффект от нововведений составил 1,1 млрд рублей, на 17% выше запланированного. На это повлиял рост продажи электронных билетов (на 30%) через мобильное приложение и переход на безбумажный формат работы с грузовыми перевозками.

Транспортная компания ПЭК больше двух лет использует большие данные. Их собирает собственный аналитический центр управления перевозками (ЦУП). Система в режиме реального времени контролирует загрузку складов в 189 пунктах по всей России, обрабатывает каждую секунду больше 500 операций и составляет прогнозы на ближайший месяц. Вот список технологий big data, которые использует ЦУП:

- Akka Framework для разработки параллельных и распределенных микросервисов на JVM;

- Spark Streaming для потоковой обработки больших данных;

- Apache Kafka для обмена сообщениями между сервисами;

- Apache Hadoop для хранения исторических данных;

- PostgreSQL для срочной отчетности;

- оперативные данные хранятся в памяти (IMDB, In-memory Database).

В ГК «Деловые линии» отмечают, что их опыт внедрения big data позволил оптимизировать затраты на топливо и улучшить сервис в компании. Сбор данных с транспортных средств и GPS-трекеров даёт оценку манеры вождения водителя, позволяет оценивать состояние машины. На основе этих данных водителям можно предлагать рекомендации по безопасному и экономичному движения, а аналитикам — тестировать гипотезы. Кроме того, у компании есть стратегический партнёр BIA-Теchnologies, который реализовал комплексный проект на технологической базе Hadoop, Qlik View и специально разработанного Self-service BI. Это инструмент для b2b-сегмента, который сократил время подготовки отчетов в 2—3 раза, уменьшил издержки на работе персонала и расходе топлива и в целом улучшил качество обслуживания.

Компаниям не обязательно нужно создавать собственные решения для грузоперевозок. На рынке развиваются аналитические сервисы, которые позволяют оптимизировать маршруты под запросы, оценивают скорость и качество работы водителей и даже регулируют количество транспорта в парке.

Например, сервис Relog помог быстрее обрабатывать обращения аптечной сети, снизил без потери качества количество грузовиков в автопарке ― с 12 до 10 и сократил расходы компании на 22—29% даже с учётом повышения зарплат водителям.

Аналитики собрали все данные по перемещению груза в одном приложении, чтобы избежать «контрольных» звонков от диспетчеров, предоставили программу для эффективного расчёта маршрутов. Система выстроила новые геозоны, исходя из загруженности аптек в каждом «квадрате» региона. Таким образом, за водителем закрепляли не просто точки на карте, а загрузку. К этому добавили KPI и за работу на более «сложных» районах водители получали хорошую доплату и мотивацию сделать работу в срок.

Плюсы и минусы профессии

Плюсы

- Профессия новая и стремительно набирает популярность.

- Большое количество клиентов заинтересовано в услугах Big Data Analyst.

- Специалисты по большим данным получают высокую заработную плату.

- Возможность получить работу мечты в крупной российской компании, например, «Яндекс» или Mail.ru Group, или деловое предложение от зарубежных корпораций, холдингов: аналитика Big Data – это дорогое удовольствие, позволить его себе могут только гиганты бизнеса или госструктуры.

- Возможен профессиональный рост и смена профиля деятельности.

Минусы

- Работа малоподвижная и однообразная.

- Часто ненормированый рабочий день.

- Постоянное психологическое напряжение.

- Нет вакансий в небольших городах, но этот недостаток компенсируется возможностью работать удаленно.

Кто и как собирает данные?

Всю работу можно условно разделить на три этапа: интеграция, управление и анализ.

Этап 1. Интеграция

На первом этапе компания должна определить цели внедрения Big Data, выбрать инструменты сбора информации, а также связать их со своими источниками поступающих данных.

Этап 2. Управление

На этом этапе выбирается платформа для хранения информации. Компании могут использовать локальные хранилища, публичные или частные облачные сервисы.

Этап 3. Аналитика

Большие данные должны работать на бизнес, однако они начинают приносить пользу после анализа. Это заключительный этап взаимодействия с ними.